[Hướng dẫn SEO] Khi nào cần chặn Googlebot crawl các trang phân trang (Pagination)?

Published on: April 01, 2023

Last updated: August 02, 2025 Xem trên toàn màn hình

Last updated: August 02, 2025 Xem trên toàn màn hình

- 05 Aug 2025

Money Site là gì? Tối ưu để tăng lợi nhuận tối đa cho website 20/73

Money Site là gì? Tối ưu để tăng lợi nhuận tối đa cho website 20/73 - 02 Dec 2023

[Giải mã SEO] Tại sao Website của Bạn Có Traffic Cao nhưng Domain Authority Thấp? Giải Mã Bí Ẩn Đằng Sau! 15/150

[Giải mã SEO] Tại sao Website của Bạn Có Traffic Cao nhưng Domain Authority Thấp? Giải Mã Bí Ẩn Đằng Sau! 15/150 - 14 Aug 2025

[Giải mã SEO] On-page keyword là gì? 15/47

[Giải mã SEO] On-page keyword là gì? 15/47 - 16 Apr 2025

Lãnh đạo linh hoạt: Hành động (Bias for Action) hay không hành động (Non-Action)? 14/65

Lãnh đạo linh hoạt: Hành động (Bias for Action) hay không hành động (Non-Action)? 14/65 - 07 Dec 2024

Link Juice: “Dòng chảy” sống còn của Off-page SEO và lý do website bắt buộc phải có 14/72

Link Juice: “Dòng chảy” sống còn của Off-page SEO và lý do website bắt buộc phải có 14/72 - 15 Aug 2025

Dự án phần mềm bị trì hoãn và vấn đề "akrasia" 14/59

Dự án phần mềm bị trì hoãn và vấn đề "akrasia" 14/59 - 11 Mar 2025

Thiên hướng Hành động (Bias for Action) và Thiên hướng Quy trình (Bias for Process) tác động tiêu cực tới "đổi mới và sáng tạo" như thế nào? 13/85

Thiên hướng Hành động (Bias for Action) và Thiên hướng Quy trình (Bias for Process) tác động tiêu cực tới "đổi mới và sáng tạo" như thế nào? 13/85 - 06 Nov 2024

Blogroll là gì và cách tận dụng hiệu quả cho blog của bạn 12/50

Blogroll là gì và cách tận dụng hiệu quả cho blog của bạn 12/50 - 01 Apr 2025

Link Exchange Scheme: Hiểu đúng, đủ và cách làm an toàn 12/57

Link Exchange Scheme: Hiểu đúng, đủ và cách làm an toàn 12/57 - 01 Jul 2023

Xây Dựng Domain Liên Kết Đa Dạng – Chiến Lược Thành Công Trong Cuộc Chiến SEO 12/144

Xây Dựng Domain Liên Kết Đa Dạng – Chiến Lược Thành Công Trong Cuộc Chiến SEO 12/144 - 14 Aug 2022

[Giải mã CMS] "Pulse" - Theo dõi và hiển thị mức độ tương tác theo thời gian thực 12/45

[Giải mã CMS] "Pulse" - Theo dõi và hiển thị mức độ tương tác theo thời gian thực 12/45 - 02 May 2023

Hiểu Đúng Chỉ Số: Linking Root Domains, Ranking Keywords và Spam Score Trên Moz 11/176

Hiểu Đúng Chỉ Số: Linking Root Domains, Ranking Keywords và Spam Score Trên Moz 11/176 - 10 Jul 2025

[Giải mã SEO] Hiểu đúng về "Direct Traffic" 10/44

[Giải mã SEO] Hiểu đúng về "Direct Traffic" 10/44 - 09 Oct 2023

Backlinks và Linking Websites: Chỉ Số Nào Mới Thực Sự Quyết Định Sức Mạnh SEO Của Bạn? 9/175

Backlinks và Linking Websites: Chỉ Số Nào Mới Thực Sự Quyết Định Sức Mạnh SEO Của Bạn? 9/175 - 06 Sep 2024

LSI Keyword là gì? SEO sẽ ra sao nếu bạn bỏ qua LSI Keyword trong chiến lược nội dung? 9/188

LSI Keyword là gì? SEO sẽ ra sao nếu bạn bỏ qua LSI Keyword trong chiến lược nội dung? 9/188 - 04 May 2025

Semantic SEO: Cách Tạo Bảng Thuật Ngữ Giúp Trang Lên Top Nhanh 9/103

Semantic SEO: Cách Tạo Bảng Thuật Ngữ Giúp Trang Lên Top Nhanh 9/103 - 12 May 2024

Groan Zone là gì? Khi mọi quan điểm va chạm, đâu là cách biến Groan Zone thành động lực đổi mới? 9/30

Groan Zone là gì? Khi mọi quan điểm va chạm, đâu là cách biến Groan Zone thành động lực đổi mới? 9/30 - 07 Aug 2025

[Giải mã SEO] WordCount - Vũ khí bí mật cải thiện SEO 8/47

[Giải mã SEO] WordCount - Vũ khí bí mật cải thiện SEO 8/47 - 02 Aug 2024

[Hướng dẫn SEO] Phân Trang (Pagination) Có Tốt Cho SEO Không? 8/108

[Hướng dẫn SEO] Phân Trang (Pagination) Có Tốt Cho SEO Không? 8/108 - 10 Aug 2020

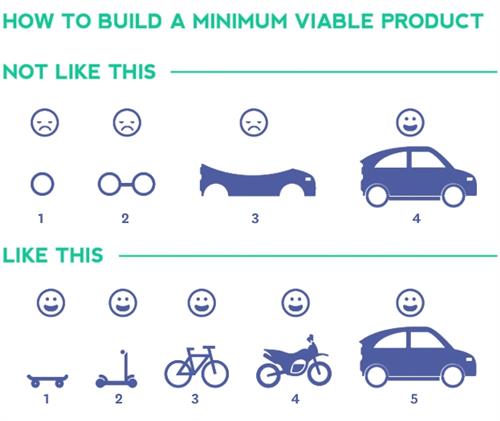

Bạn có biết quy tắc thất bại nhanh: Fail early, fail often, fail cheap, but always fail forward 7/156

Bạn có biết quy tắc thất bại nhanh: Fail early, fail often, fail cheap, but always fail forward 7/156 - 21 Mar 2024

[Hướng dẫn SEO] "URL phụ" là gì? 6/66

[Hướng dẫn SEO] "URL phụ" là gì? 6/66 - 26 Mar 2025

[SEO Website] "Tín hiệu buzz" là gì? 5/78

[SEO Website] "Tín hiệu buzz" là gì? 5/78 - 19 May 2024

[Giải mã Ahrefs] "Total Organic Keywords" là gì? 5/49

[Giải mã Ahrefs] "Total Organic Keywords" là gì? 5/49

Tình huống: Chặn Googlebot crawl các trang phân trang

Một admin web blog cấu hình file robots.txt như sau:

User-agent: * Disallow: /blog?page=

Hoặc:

User-agent: * Disallow: /*?page=

Giải thích:

-

Disallow: /blog?page=có nghĩa là Googlebot sẽ không được phép crawl bất kỳ URL nào có chuỗi/blog?page=, chẳng hạn:/blog?page=2/blog?page=3

-

Dòng

Disallow: /*?page=còn nguy hiểm hơn vì nó áp dụng cho toàn bộ website, bất kỳ URL nào có?page=đều bị chặn.

Hậu quả đối với SEO

Google không thể crawl các trang tiếp theo

- Chỉ crawl được

/bloghoặc/blog?page=1 - Mọi bài viết nằm ở các trang sau (trang 2, 3, 4...) sẽ không bao giờ được Google nhìn thấy

Mất index các nội dung quan trọng

- Nếu nội dung cũ, hoặc sản phẩm nằm ở trang 2-10, Google sẽ không index chúng

- Website có nguy cơ mất hàng loạt cơ hội hiển thị trên Google

Tỷ lệ index thấp hơn crawl budget

Google bot sẽ dừng lại ở trang đầu và nghĩ rằng website của bạn ít nội dung → ảnh hưởng đến đánh giá chất lượng tổng thể của site.

Khi nào có thể dùng chặn này?

Chỉ nên chặn nếu:

- Bạn có hệ thống phân trang vô hạn (infinite scroll) và các trang sau là nội dung lặp lại hoặc không quan trọng

- Bạn muốn hợp nhất toàn bộ nội dung về trang đầu tiên và không muốn bị index trùng lặp

- Bạn đã dùng canonical hợp lý và thiết lập sơ đồ site XML để khai báo nội dung chính

Lời khuyên (Best Practices)

Thay vì chặn, hãy để Google crawl các trang phân trang, nhưng:

- Tối ưu internal link rõ ràng

- Dùng canonical chuẩn

- Đảm bảo nội dung ở các trang sau vẫn có giá trị SEO

Kết luận

Không nên chặn phân trang trong robots.txt trừ khi bạn hiểu rõ hậu quả và đã có chiến lược SEO thay thế để Google không bỏ sót nội dung quan trọng.

[{"displaySettingInfo":"[{\"isFullLayout\":false,\"layoutWidthRatio\":\"\",\"showBlogMetadata\":true,\"showAds\":true,\"showQuickNoticeBar\":true,\"includeSuggestedAndRelatedBlogs\":true,\"enableLazyLoad\":true,\"quoteStyle\":\"1\",\"bigHeadingFontStyle\":\"1\",\"postPictureFrameStyle\":\"1\",\"isFaqLayout\":false,\"isIncludedCaption\":false,\"faqLayoutTheme\":\"1\",\"isSliderLayout\":false}]"},{"articleSourceInfo":"[{\"sourceName\":\"\",\"sourceValue\":\"\"}]"},{"privacyInfo":"[{\"isOutsideVietnam\":false}]"},{"tocInfo":"[{\"isEnabledTOC\":true,\"isAutoNumbering\":false,\"isShowKeyHeadingWithIcon\":false}]"},{"termSettingInfo":"[{\"showTermsOnPage\":true,\"displaySequentialTermNumber\":true}]"}]

Nguồn

{content}

Link copied!

Link copied!

Mới cập nhật

Mới cập nhật