Giải mã 10 "Pain Points" của Big Data: Khi "mỏ vàng dữ liệu" vẫn không thể khai thác

Last updated: August 26, 2025 Xem trên toàn màn hình

- 11 May 2021

Khác nhau giữa Padding và Buffer trong quản lý rủi ro dự án 100/1031

Khác nhau giữa Padding và Buffer trong quản lý rủi ro dự án 100/1031 - 17 Aug 2020

Mục tiêu dự án là gì? Làm thế nào để xác định mục tiêu? 77/374

Mục tiêu dự án là gì? Làm thế nào để xác định mục tiêu? 77/374 - 04 Mar 2020

Kinh nghiệm lập dự toán chi phí dự án phần mềm theo phương pháp Man-Month 65/2703

Kinh nghiệm lập dự toán chi phí dự án phần mềm theo phương pháp Man-Month 65/2703 - 19 Aug 2025

Lập dự toán chi phí và thời gian cho dự án Software Outsourcing Project 60/109

Lập dự toán chi phí và thời gian cho dự án Software Outsourcing Project 60/109 - 14 Aug 2022

Khác biệt giữa tiêu chí hoàn thành DOD (Definition of Done) với tiêu chí nghiệm thu (Acceptance Criteria) 55/631

Khác biệt giữa tiêu chí hoàn thành DOD (Definition of Done) với tiêu chí nghiệm thu (Acceptance Criteria) 55/631 - 15 Apr 2020

Phần mềm BPM là gì? So sánh với ERP và các phần mềm Workflows 51/691

Phần mềm BPM là gì? So sánh với ERP và các phần mềm Workflows 51/691 - 08 Aug 2019

10 lý do tại sao việc sử dụng và vận hành phần mềm điều hành doanh nghiệp không được hiệu quả 47/199

10 lý do tại sao việc sử dụng và vận hành phần mềm điều hành doanh nghiệp không được hiệu quả 47/199 - 01 Jul 2023

Phương pháp Shuhari - Làm sao học ít hiểu nhiều? 39/1114

Phương pháp Shuhari - Làm sao học ít hiểu nhiều? 39/1114 - 08 Feb 2021

Quy trình nâng cấp phần mềm quản trị doanh nghiệp ERP 37/273

Quy trình nâng cấp phần mềm quản trị doanh nghiệp ERP 37/273 - 01 Sep 2023

"Data steward" là gì? 36/502

"Data steward" là gì? 36/502 - 10 Jul 2021

Padding là gì? Tại sao padding cần thiết cho Project Estimation? 36/410

Padding là gì? Tại sao padding cần thiết cho Project Estimation? 36/410 - 01 Aug 2022

"Sponsored Content" là gì? Khác nhau giữa Sponsored Content và Native Advertising? 33/933

"Sponsored Content" là gì? Khác nhau giữa Sponsored Content và Native Advertising? 33/933 - 02 May 2025

Vì sao học giỏi mà vẫn nghèo, học dốt lại thành đạt trong cuộc sống? 33/109

Vì sao học giỏi mà vẫn nghèo, học dốt lại thành đạt trong cuộc sống? 33/109 - 07 Jan 2025

Phân biệt Proxy, HMA và VPN 32/365

Phân biệt Proxy, HMA và VPN 32/365 - 01 Sep 2020

Co-founder là gì? Vai trò của các Co-Founder khi lập nghiệp. 32/323

Co-founder là gì? Vai trò của các Co-Founder khi lập nghiệp. 32/323 - 19 Aug 2024

Kiểm toán công nghệ thông tin (IT Audit) - Nghề mới mẻ ở Việt Nam 31/556

Kiểm toán công nghệ thông tin (IT Audit) - Nghề mới mẻ ở Việt Nam 31/556 - 03 Feb 2020

Sản phẩm OEM và ODM là gì? 28/567

Sản phẩm OEM và ODM là gì? 28/567 - 19 Aug 2020

Lift & Shift - Phương pháp tối ưu dịch chuyển hệ thống phần mềm qua đám mây 27/238

Lift & Shift - Phương pháp tối ưu dịch chuyển hệ thống phần mềm qua đám mây 27/238 - 02 Aug 2025

Cloud vs On-Premise vs Hybrid: Lựa chọn nào phù hợp nhất cho vận hành phần mềm doanh nghiệp? 27/122

Cloud vs On-Premise vs Hybrid: Lựa chọn nào phù hợp nhất cho vận hành phần mềm doanh nghiệp? 27/122 - 05 Aug 2024

Giải mã 10 sai lầm về quản lý thay đổi 26/426

Giải mã 10 sai lầm về quản lý thay đổi 26/426 - 25 Apr 2018

Bảo hộ bản quyền phần mềm dưới khía cạnh sở hữu trí tuệ như thế nào? 25/229

Bảo hộ bản quyền phần mềm dưới khía cạnh sở hữu trí tuệ như thế nào? 25/229 - 04 Mar 2025

So sánh các giải pháp Sales Loft, Power BI và Salesforce 25/112

So sánh các giải pháp Sales Loft, Power BI và Salesforce 25/112 - 09 Feb 2021

Tầm nhìn là gì? Tí dụ minh họa cụ thể về tầm nhìn 25/188

Tầm nhìn là gì? Tí dụ minh họa cụ thể về tầm nhìn 25/188 - 28 Aug 2025

Tổng quan tất cả các RỦI RO trong cuộc sống 25/58

Tổng quan tất cả các RỦI RO trong cuộc sống 25/58 - 02 Jan 2024

Domain Engineering là gì? 25/505

Domain Engineering là gì? 25/505 - 07 Feb 2024

Vì sao Scrum Team thường bị Spillover / Carry Over? 24/31

Vì sao Scrum Team thường bị Spillover / Carry Over? 24/31 - 04 Jan 2023

Enterprise Forms Automation là gì? Vì Sao Tự Động Hóa Biểu Mẫu Trở Thành Lựa Chọn Tất Yếu? 23/51

Enterprise Forms Automation là gì? Vì Sao Tự Động Hóa Biểu Mẫu Trở Thành Lựa Chọn Tất Yếu? 23/51 - 16 Apr 2025

Lãnh đạo linh hoạt: Hành động (Bias for Action) hay không hành động (Non-Action)? 23/77

Lãnh đạo linh hoạt: Hành động (Bias for Action) hay không hành động (Non-Action)? 23/77 - 18 Mar 2018

Dịch vụ Hosting cho Website là gì? Các lời khuyên chọn Hosting tốt nhất 21/298

Dịch vụ Hosting cho Website là gì? Các lời khuyên chọn Hosting tốt nhất 21/298 - 01 Apr 2022

Chi phí nhà thầu phụ chiếm bao nhiêu phần trăm gói thầu? 20/189

Chi phí nhà thầu phụ chiếm bao nhiêu phần trăm gói thầu? 20/189 - 08 Apr 2024

Hiệu ứng Matthew: Tác động và Ứng dụng trong Chuyển đổi Số và Công nghệ tại Việt Nam 20/227

Hiệu ứng Matthew: Tác động và Ứng dụng trong Chuyển đổi Số và Công nghệ tại Việt Nam 20/227 - 10 Aug 2020

Bạn có biết quy tắc thất bại nhanh: Fail early, fail often, fail cheap, but always fail forward 20/176

Bạn có biết quy tắc thất bại nhanh: Fail early, fail often, fail cheap, but always fail forward 20/176 - 28 Feb 2025

“Học giỏi” hay “giỏi học”? 19/171

“Học giỏi” hay “giỏi học”? 19/171 - 11 Mar 2025

Thiên hướng Hành động (Bias for Action) và Thiên hướng Quy trình (Bias for Process) tác động tiêu cực tới "đổi mới và sáng tạo" như thế nào? 18/105

Thiên hướng Hành động (Bias for Action) và Thiên hướng Quy trình (Bias for Process) tác động tiêu cực tới "đổi mới và sáng tạo" như thế nào? 18/105 - 12 May 2021

Các yêu cầu thay đổi (Change Requests) - nỗi ám ảnh của team dự án phần mềm 18/456

Các yêu cầu thay đổi (Change Requests) - nỗi ám ảnh của team dự án phần mềm 18/456 - 03 Oct 2021

Khác biệt giữa thiết kế phần mềm và thiết kế công trình xây dựng 17/548

Khác biệt giữa thiết kế phần mềm và thiết kế công trình xây dựng 17/548 - 26 Mar 2025

Từ điển tất cả các chức danh trong lĩnh vực CNTT và Chuyển Đổi Số 17/98

Từ điển tất cả các chức danh trong lĩnh vực CNTT và Chuyển Đổi Số 17/98 - 04 Jan 2023

Đánh giá nhân sự theo chuẩn người Nhật 16/459

Đánh giá nhân sự theo chuẩn người Nhật 16/459 - 08 Aug 2023

"Denormalized Table" là gì? 15/214

"Denormalized Table" là gì? 15/214 - 01 May 2022

Nghệ thuật quản lý rủi ro của người Nhật - kinh nghiệm cho BrSE 14/237

Nghệ thuật quản lý rủi ro của người Nhật - kinh nghiệm cho BrSE 14/237 - 01 May 2023

[Tư vấn CNTT] Quản lý ngân sách CNTT cho doanh nghiệp 14/231

[Tư vấn CNTT] Quản lý ngân sách CNTT cho doanh nghiệp 14/231 - 01 May 2022

Có thể xác định vị trí địa lý của địa chỉ IP với độ chính xác đến từng địa chỉ con phố? 13/522

Có thể xác định vị trí địa lý của địa chỉ IP với độ chính xác đến từng địa chỉ con phố? 13/522 - 04 Sep 2023

Giải mã nhóm tính cách (ISTP - Nhà kỹ thuật) 13/271

Giải mã nhóm tính cách (ISTP - Nhà kỹ thuật) 13/271 - 08 Mar 2020

Vì sao doanh nghiệp cần phải tạo Web bán hàng? 13/183

Vì sao doanh nghiệp cần phải tạo Web bán hàng? 13/183 - 01 Dec 2022

Quản trị rủi ro trong dự án phần mềm 13/320

Quản trị rủi ro trong dự án phần mềm 13/320 - 01 Feb 2022

Thách thức với doanh nghiệp chuyển đổi số trong thời đại VUCA 13/795

Thách thức với doanh nghiệp chuyển đổi số trong thời đại VUCA 13/795 - 18 Jul 2024

Các chuyên gia tư vấn sử dụng các thuật ngữ Lean & Agile trong các dự án thực tế như thế nào? 13/64

Các chuyên gia tư vấn sử dụng các thuật ngữ Lean & Agile trong các dự án thực tế như thế nào? 13/64 - 19 Jul 2023

3 cấp độ của thất bại và bí quyết "cái khó ló cái khôn" 13/105

3 cấp độ của thất bại và bí quyết "cái khó ló cái khôn" 13/105 - 14 May 2024

Chiến lược răng lược là gì? Làm thế nào để tận dụng chiến lược răng lược trong kinh doanh? 12/248

Chiến lược răng lược là gì? Làm thế nào để tận dụng chiến lược răng lược trong kinh doanh? 12/248 - 08 Sep 2024

Da Thịt Trong Cuộc Chơi - Skin In The Game 12/364

Da Thịt Trong Cuộc Chơi - Skin In The Game 12/364 - 16 Aug 2025

Hoài nghi khoa học với 20 thuật ngữ bi quan về hiệu quả của Scrum 11/59

Hoài nghi khoa học với 20 thuật ngữ bi quan về hiệu quả của Scrum 11/59 - 18 Sep 2025

Bị sa thải sau 25 năm làm việc trong lĩnh vực công nghệ: Nỗi lo lắng, sự hy sinh và thực tế mà không ai dám nhắc đến 11/29

Bị sa thải sau 25 năm làm việc trong lĩnh vực công nghệ: Nỗi lo lắng, sự hy sinh và thực tế mà không ai dám nhắc đến 11/29 - 01 May 2024

Tổng hợp các thuật ngữ lĩnh vực tư vấn CNTT 10/78

Tổng hợp các thuật ngữ lĩnh vực tư vấn CNTT 10/78 - 30 Jan 2026

Vượt qua cơn bão sa thải nhân viên công nghệ: Những đêm thức trắng, phần mềm bị lỗi và hội chứng kẻ giả mạo (Impostor Syndrome) 9/18

Vượt qua cơn bão sa thải nhân viên công nghệ: Những đêm thức trắng, phần mềm bị lỗi và hội chứng kẻ giả mạo (Impostor Syndrome) 9/18 - 09 Feb 2025

Làm gì nếu người quản lý luôn thúc ép: "Đừng làm forwarder, hãy là solver"? 9/14

Làm gì nếu người quản lý luôn thúc ép: "Đừng làm forwarder, hãy là solver"? 9/14 - 17 Feb 2018

Hệ luỵ khi sử dụng Web Hosting từ nhà cung cấp kém chất lượng 9/188

Hệ luỵ khi sử dụng Web Hosting từ nhà cung cấp kém chất lượng 9/188 - 08 Mar 2022

Mô hình nguồn mở hoạt động ra sao? 8/235

Mô hình nguồn mở hoạt động ra sao? 8/235 - 09 Dec 2024

10 nghịch lý quản trị khiến tổ chức mãi loay hoay 8/148

10 nghịch lý quản trị khiến tổ chức mãi loay hoay 8/148 - 17 Feb 2026

Giá trị con người nằm ở đâu trong thời đại AI và Robot? 7/9

Giá trị con người nằm ở đâu trong thời đại AI và Robot? 7/9 - 07 Feb 2024

Thất bại của nhóm Scrum - Phân loại các mô hình phản tác dụng trong Scrum (Scrum Anti-Patterns) 6/14

Thất bại của nhóm Scrum - Phân loại các mô hình phản tác dụng trong Scrum (Scrum Anti-Patterns) 6/14 - 29 Jun 2025

Làm Thế Nào Để "Nhiệm Vụ Thử Thách" (Stretch Assignment) Không Là "Nỗi Đau" Của Nhân Sự? 6/52

Làm Thế Nào Để "Nhiệm Vụ Thử Thách" (Stretch Assignment) Không Là "Nỗi Đau" Của Nhân Sự? 6/52 - 15 Aug 2025

Dự án phần mềm bị trì hoãn và vấn đề "akrasia" 5/72

Dự án phần mềm bị trì hoãn và vấn đề "akrasia" 5/72 - 12 May 2024

Groan Zone là gì? Khi mọi quan điểm va chạm, đâu là cách biến Groan Zone thành động lực đổi mới? 4/43

Groan Zone là gì? Khi mọi quan điểm va chạm, đâu là cách biến Groan Zone thành động lực đổi mới? 4/43

Big Data đang là "mùi vị" thời thượng, khi các công ty thuộc mọi quy mô và ngành nghề đều đổ xô lên chuyến tàu dữ liệu lớn. Tuy nhiên, chính trong quá trình triển khai – và cả sau đó – nhiều doanh nghiệp mới bắt đầu nhận ra những thực tế khắc nghiệt của Big Data. Tất cả tiềm năng và lợi ích mà nó mang lại chỉ trở thành hiện thực nếu các điểm nghẽn đi kèm được giải quyết thỏa đáng.

Dưới đây là 10 nỗi đau (pain point) lớn nhất liên quan đến Big Data:

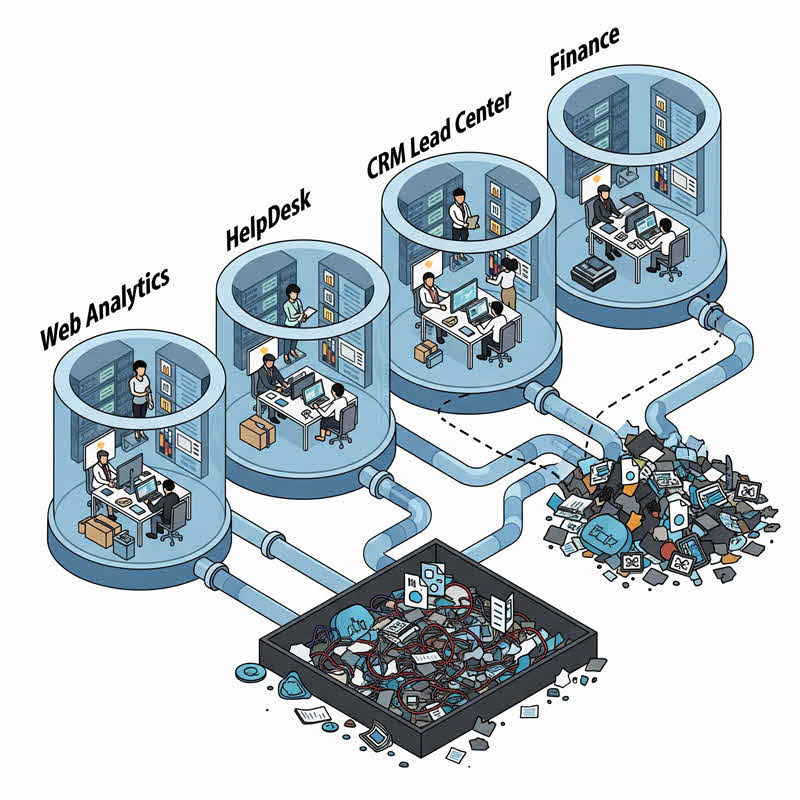

1. Dữ liệu bị “nhốt” trong các kho riêng biệt (Data Trapped in Silos)

Thách thức đầu tiên mà bất kỳ nhà phân tích dữ liệu nào cũng gặp phải là hợp nhất dữ liệu trong toàn doanh nghiệp. Dữ liệu không chỉ nằm rải rác ở nhiều hệ thống khác nhau, mà còn bị "nhốt" trong các silo – nhiều trong số đó không thể truy cập được hoặc thậm chí chưa được đưa lên trực tuyến. Thậm chí, một số dữ liệu còn chưa được số hóa.

Ví dụ, một nhà phân tích đang tìm hiểu hành vi khách hàng có thể thấy mỗi cửa hàng lưu trữ dữ liệu riêng lẻ, một số thì còn ở dạng giấy. Dữ liệu thường là sự kết hợp giữa dạng có cấu trúc (từ hệ thống nội bộ, cơ sở dữ liệu) và không cấu trúc (email, nhật ký hệ thống, mạng xã hội…).

Nếu dữ liệu bị chia cắt và không được thống nhất, việc phân tích sẽ bị sai lệch, dẫn đến kết quả méo mó.

2. Quá tải dữ liệu (Data Overload)

Trái ngược với tình trạng thiếu dữ liệu là tình trạng dữ liệu quá tải. Trong thế giới số hiện nay, dữ liệu đang tăng với tốc độ chóng mặt – hơn 2,5 triệu tỷ byte dữ liệu được tạo ra mỗi ngày từ cảm biến, mạng xã hội, giao dịch, thiết bị di động...

Nhiều tổ chức thu thập tất cả mọi thứ có thể, khiến kho dữ liệu và hệ thống phân tích bị "ngộp". Phần lớn dữ liệu có thể trùng lặp, dư thừa hoặc không liên quan, làm cản trở việc tìm ra thông tin có giá trị.

3. Diễn giải dữ liệu sai ngữ cảnh (Data Interpretation)

Hiểu rõ nguồn gốc và bối cảnh của dữ liệu là điều thiết yếu. Ví dụ, dữ liệu từ mạng xã hội cần được phân tích trong ngữ cảnh hành vi người dùng. Nếu không hiểu đúng ngữ cảnh, kết quả phân tích có thể sai lệch.

Giải pháp: Sử dụng công cụ trực quan hóa dữ liệu (data visualization) để diễn giải tốt hơn.

4. Làm sạch dữ liệu (Data Cleansing)

Liên quan mật thiết đến việc hiểu dữ liệu là làm sạch dữ liệu. Dữ liệu thô có thể thiếu tiêu đề, định dạng sai, chứa ký tự lạ… Việc chuẩn hóa là cần thiết để đảm bảo tính nhất quán. Tuy nhiên, đây là công đoạn thường bị đánh giá thấp và mất nhiều thời gian hơn cả phân tích thống kê.

5. Thách thức kỹ thuật liên quan đến xử lý (Technical Challenges with Processors)

Big Data đòi hỏi khả năng xử lý rất lớn. GPU (bộ xử lý đồ họa) hiệu quả hơn CPU truyền thống nhưng lại khó lập trình hơn nhiều. Việc lập trình GPU yêu cầu cam kết với một mô hình cụ thể (AMD, Nvidia, Intel...), điều này làm tăng độ phức tạp kỹ thuật cho lập trình phân tích dữ liệu lớn.

6. Xử lý khối lượng dữ liệu khổng lồ trong thời gian ngắn

Tốc độ là yếu tố cạnh tranh then chốt. Các công ty cần hạ tầng IT đủ mạnh để đọc dữ liệu nhanh và đưa ra insight theo thời gian thực.

Apache Hadoop là framework phổ biến để lưu trữ và xử lý dữ liệu phân tán, nhưng nó gặp khó khăn trong quản lý tài nguyên, chia sẻ dữ liệu và lập lịch. Các giải pháp thương mại như IBM InfoSphere BigInsights, Cloudera, Hortonworks giúp khắc phục điểm yếu này.

7. Khả năng mở rộng (Scalability)

Hai yếu tố hạ tầng quan trọng nhất là lưu trữ và xử lý. Việc mở rộng nhiều workload khác nhau là thách thức. Lý tưởng nhất là hệ thống có thể phân bổ tài nguyên xử lý linh hoạt theo nhu cầu, nhưng hiện tại điều này đòi hỏi phải viết mã khá phức tạp.

8. Bảo mật (Security)

Big Data đi kèm với rủi ro lớn về bảo mật. Dữ liệu đến từ nhiều nguồn, dễ bị chèn Trojan hoặc bị thao túng trong quá trình xử lý. Các công cụ như Hadoop hay NoSQL không được thiết kế tối ưu về bảo mật.

Ngoài ra, việc xử lý dữ liệu trên đám mây khiến rủi ro mất cắp dữ liệu càng tăng. Các giải pháp xác thực hiện có cũng rất hạn chế. Ví dụ: xác thực và phân quyền đòi hỏi hai bộ stack khác nhau, không đồng bộ với toàn bộ hệ sinh thái Hadoop. Nguyên nhân chính là do mỗi nhà cung cấp lại giữ phần tích hợp LDAP như một tính năng độc quyền.

9. Chi phí (Budget)

Phân tích Big Data tốn kém, và dễ vượt ngân sách ban đầu.

Các dự án thường cần thực hiện quy trình ETL (Extract – Transform – Load) với nhiều công cụ như Flume (streaming), Oozie (lập lịch), Kettle (giao diện trực quan), Pig (chuyển đổi dữ liệu phức tạp), Sqoop (chuyển dữ liệu số lượng lớn)… Việc viết code tích hợp tất cả công cụ này là rất phức tạp và không có giải pháp liền mạch.

10. Chọn công cụ phân tích phù hợp (Tool Selection)

Việc quyết định cách thu thập – lưu trữ – phân tích dữ liệu là một chuyện, nhưng chọn công cụ phù hợp lại là chuyện khác.

Việc chuyển từ công cụ này sang công cụ khác là rất khó khăn. Hệ quả là nhiều công ty xây hệ thống hoàn hảo nhưng lại chọn sai công cụ phân tích, khiến cả dự án trở nên kém hiệu quả.

Ba yếu tố quan trọng khi chọn công cụ:

- Khối lượng dữ liệu

- Số lượng giao dịch

- Hệ thống và ứng dụng kế thừa (legacy)

Nhiều tổ chức chỉ chú ý đến 2 yếu tố đầu, bỏ qua yếu tố thứ 3 – dẫn đến khó tích hợp hệ thống mới với hệ thống cũ.

Dịch bởi Nguyễn Thị Kiều

TIGO Consulting

Nguồn: Suyati

Link copied!

Link copied!

Mới cập nhật

Mới cập nhật